|

Cours |

|

|

|

|

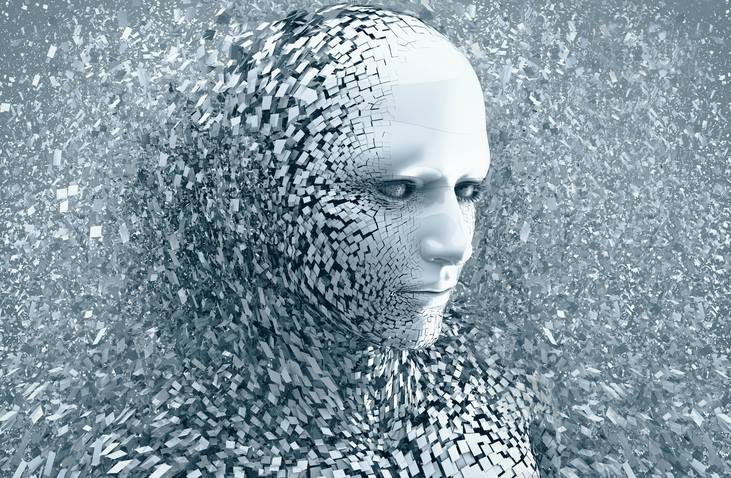

- Introduction (Résumé) L’intelligence

artificielle (IA) est une technologie qui utilise des algorithmes et des

réseaux de neurones pour analyser, L’intelligence

artificielle (IA) a évolué par cycles de progrès et de stagnation depuis les

années 1940, passant - Résolution des problèmes et jeux (Résumé) L’IA

moderne résout des problèmes et optimise les jeux grâce à des algorithmes

avancés comme MiniMax, MCTS - Applications des probabilités. (Résumé) Les

probabilités, via le théorème de Bayes, permettent de gérer l'incertitude en

IA, notamment pour la classification, - Systèmes experts (Résumé) (note) Les

systèmes experts, issus de l’IA symbolique, utilisent une base de

connaissances et un moteur d’inférence - Utilisation des Chatbots (Résumé) Les

chatbots modernes, comme ChatGPT, Bing Copilot et Gemini, utilisent l'IA pour

interagir avec les utilisateurs, - Apprentissage et machine learning (Résumé) Le

document explore l’apprentissage humain et automatique, décrivant les types

de machine learning - Perceptron et réseaux de neurones (Résumé) L'évolution

des réseaux de neurones, du perceptron simple à la rétropropagation et au

deep learning, a permis - Reconnaissance de chiffres manuscrits (Résumé) L'évolution

des modèles de reconnaissance des chiffres manuscrits, du perceptron simple aux

réseaux convolutifs, - Réseaux convolutifs (Résumé) Les

réseaux convolutifs (CNN) optimisent la reconnaissance d’images en extrayant

des caractéristiques hiérarchiques, Les techniques de détection d’objets par vision par ordinateur,

en détaillant les algorithmes CNN, leurs applications Le

TALN (Traitement Automatique du Langage Naturel) permet aux machines de

comprendre et traiter le langage humain Les

modèles avancés du TALN, notamment les RNN, LSTM, Transformers et le

mécanisme d’attention, - LLM – Grands modèles de langage – 1ère partie (Résumé) Les

grands modèles de langage (LLM) ont progressé grâce aux transformers,

introduits en 2017. - LLM – Grands modèles de langage – 2ème partie (Résumé) Le

Traitement Automatique du Langage Naturel (TALN) utilise des modèles

d’intelligence artificielle, des RNN - Attention au Transformer ! (Résumé) (note) Le Transformer, introduit en 2017, révolutionne le

traitement du langage naturel grâce à l’auto-attention, Document original "Attention is all you need". - Gouvernance mondiale (Résumé) (note) L'IA

Act européen encadre l'usage de l’intelligence artificielle en interdisant

certains systèmes à risque, en imposant - Conclusion (Résumé) L’IA

Générale (AGI) représente une avancée majeure avec des opportunités et des

risques,

|

|

|